Meta Connect 2024 est terminé. Mark Zuckerberg a pris la parole mercredi pour faire des annonces dans plusieurs catégories de produits.

Bien qu’il y ait quelques nouvelles fonctionnalités à venir sur des applications familières comme Instagram, Facebook et WhatsApp, Meta Connect était surtout axé sur d’autres projets de l’entreprise, à savoir le Meta Quest, des lunettes intelligentes, et bien sûr, l’IA.

Un Meta Quest 3 moins cher

Enfin, une version du Meta Quest 3 qui ne coûte pas 500 $. Le Meta Quest 3S intègre la plupart des caractéristiques qui rendaient le Quest 3 intéressant dans un appareil qui est presque aussi abordable que le Quest 2 à son apogée. À partir de 299 $, il est équipé de la même puce Qualcomm Snapdragon XR2 Gen 2 et des mêmes contrôleurs Touch Plus (sans anneau autour des doigts), et il offre en fait une autonomie légèrement meilleure (Meta affirme qu’il donne 2,5 heures contre 2,2 heures sur le Quest 3 original). Sa disposition de caméra, qui possède 3 capteurs de chaque côté de l’appareil, est également un peu plus attrayante, du moins à mon avis en tant que propriétaire d’un Quest 3.

Crédit : Meta

Cela ne veut pas dire qu’il n’y a pas de compromis avec le modèle moins cher. Bien que le 3S puisse exécuter toutes les applications que le Quest 3 standard peut, en plus de maintenir un passage en couleur complet, l’affichage a une résolution inférieure. Au lieu d’une résolution par œil de 2064 x 2208, vous obtenez des chiffres identiques à ceux du Quest 2, à 1832 x 1920. Le champ de vision a également été réduit d’un maximum de 110 degrés à un maximum de 96 degrés, et il n’y a pas de capteur de profondeur. Mais écoutez, il y a maintenant un véritable bouton pour passer de la RA à la RV, donc vous n’avez pas à double-taper sur le côté de l’appareil.

Le Quest 3S remplace officiellement le Quest 2, et Meta met également fin aux ventes du Quest Pro, donc je suppose que le Quest 3 est maintenant techniquement son casque de niveau pro (il a de toute façon une résolution plus élevée). La société affirme qu’elle continuera à vendre le Quest 2 et Pro jusqu’à épuisement des stocks (ou jusqu’à la fin de l’année, même si des stock sont encore disponibles), donc si vous en voulez un, c’est votre dernière chance.

Mais vous serez probablement mieux servi en choisissant une version du Quest 3. Le Quest 3S à 299 $ dispose de 128 Go de stockage, ou vous pouvez passer à une version de 256 Go pour 399 $. Le Quest 3 régulier continuera à coûter 499 $, mais toutes les versions seront désormais accompagnées de Batman : Arkham Shadow, qui sort le 22 octobre. Les précommandes du Quest 3S sont ouvertes, avec une sortie prévue pour le 15 octobre.

Une nouvelle version de Llama 3.2, le modèle IA de Meta

Meta a également annoncé la dernière version de Llama, son modèle IA. Llama 3.2 succède à Llama 3.1 de juillet, et se décline en différentes variantes : deux LLMs visuels (petit et moyen), ainsi que deux modèles uniquement texte (1B et 3B), en fonction de la manière dont le modèle doit être mis en œuvre. Meta affirme que ces modèles sont prêts à l’emploi dès aujourd’hui pour le matériel Qualcomm et MediaTek, et optimisés pour les processeurs Arm.

Meta indique que les deux modèles uniquement texte supportent 128k tokens, et sont “à la pointe de leur catégorie” lorsqu’ils sont utilisés sur le dispositif pour des tâches comme résumer, réécrire et suivre des instructions. Les modèles de vision, quant à eux, peuvent échanger leurs équivalents modèles texte, et Meta affirme qu’ils peuvent rivaliser avec des modèles fermés comme Claude 3 Haiku. Les modèles sont disponibles en téléchargement depuis llama.com et Hugging Face.

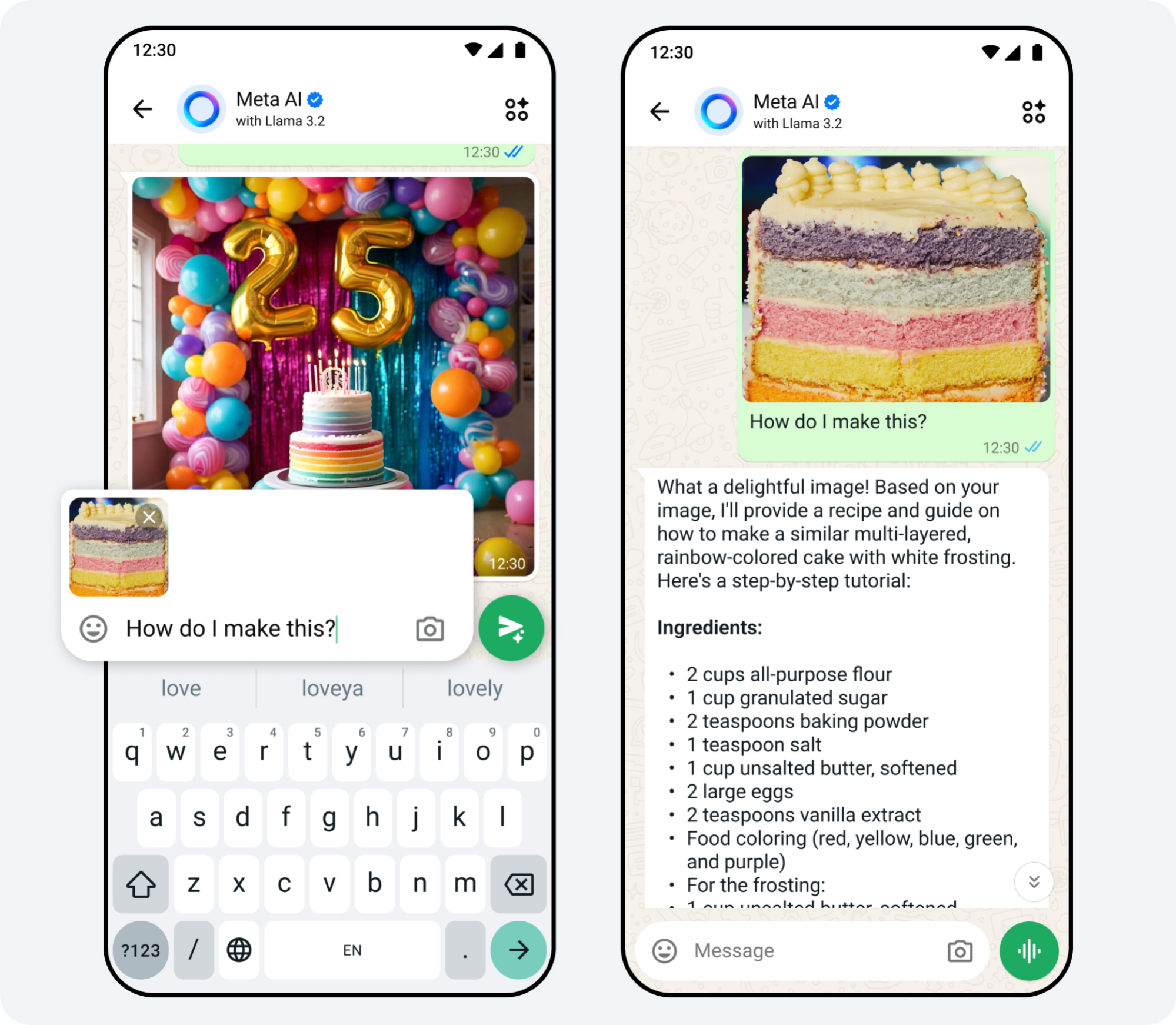

Bien que cela soit formidable pour les développeurs, pour le reste d’entre nous, Llama 3.2 est également disponible via l’assistant de Meta, Meta AI. Comme il se trouve, le chatbot était également le sujet de plusieurs annonces lors de Meta Connect 2024.

Quelles sont les nouveautés de Meta AI

Pour les entreprises d’IA, il ne suffit pas d’échanger des textes avec vos bots IA : La nouvelle tendance est de parler avec votre compagnon numérique. Meta va bientôt déployer cette capacité pour Meta AI, et lorsque cela arrivera, vous pourrez discuter avec l’assistant dans des applications Meta comme Facebook, Instagram et WhatsApp, et le bot répondra de la même manière. Ce sont toutes les mêmes réponses que vous obtiendriez habituellement de Meta AI, mais simplement exprimées à voix haute. Comme avec d’autres bots IA parlants, vous pouvez choisir parmi différentes voix IA, y compris des options de célébrités comme Awkwafina, Dame Judi Dench, John Cena, Keegan Michael Key et Kristen Bell.

L’annonce intervient juste après le déploiement complet du mode vocal avancé d’OpenAI, qui offre aux abonnés payants une expérience plus “naturelle” lors de la conversation avec ChatGPT.

Meta AI comprend désormais mieux les images. Vous pouvez télécharger une image et demander à Meta AI d’identifier des sujets, comme un type de fleur spécifique, ou publier une photo d’un plat pour lequel vous aimeriez avoir la recette. (Je suis sceptique quant à la capacité de Meta AI à élaborer une recette à partir d’une photo, mais nous verrons). Meta AI peut également “photoshoper” vos images : Meta affirme que le bot peut changer votre tenue ou remplacer complètement l’arrière-plan, par exemple.

En parlant de fonds, lorsque vous partagez une photo de votre fil vers votre histoire, Meta AI peut analyser la photo et générer un fonds complémenataire pour votre publication.

Crédit : Meta

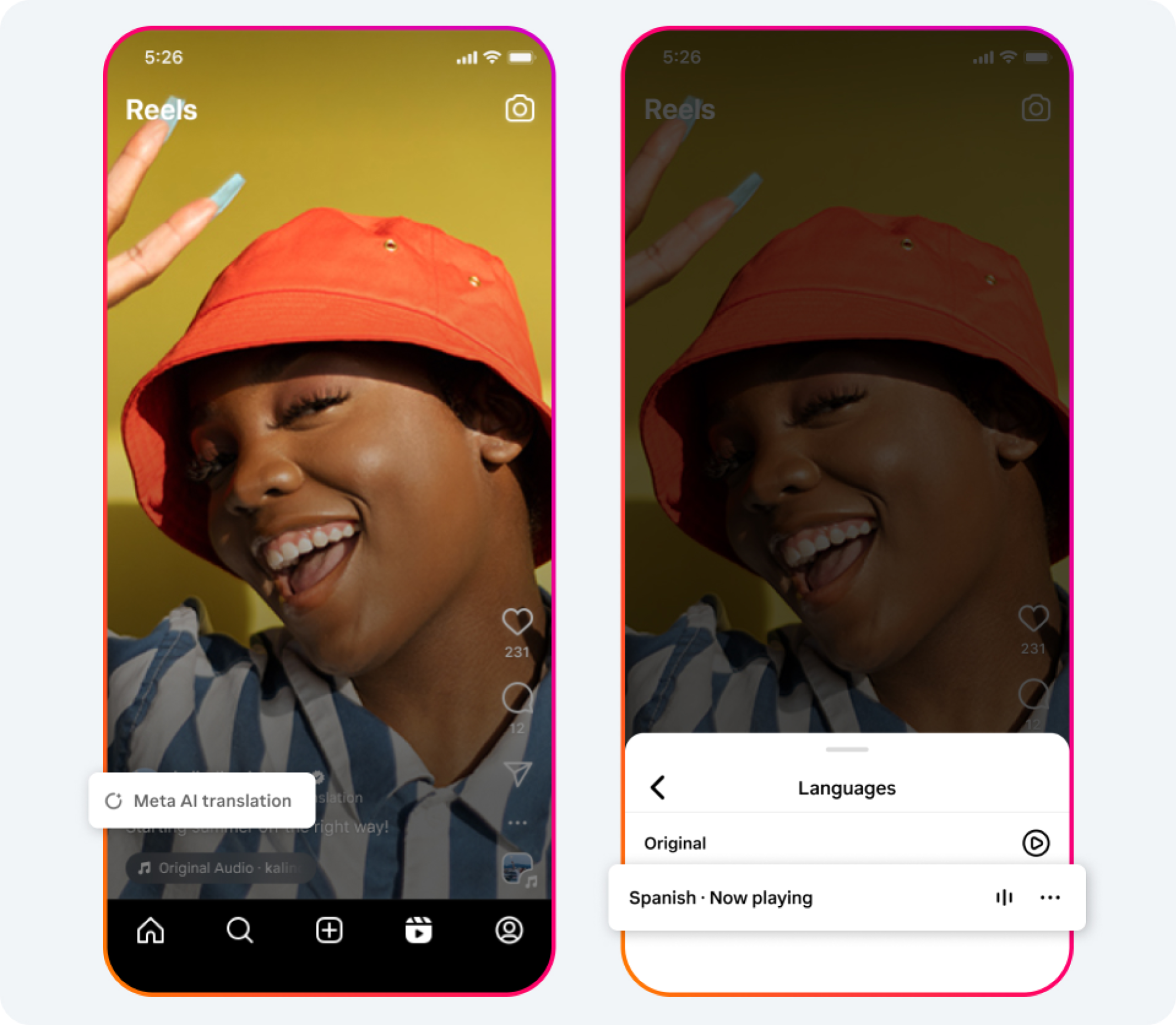

Meta affirme également travailler sur une fonctionnalité de traduction en direct pour les Reels. Une fois lancée, cette fonctionnalité traduira l’audio des Reels dans une langue cible, avec un doublage et un synchronisation labiale automatiques. Selon Meta, Meta AI peut essentiellement cloner la voix du locuteur, la traduire et l’adapter à son style de parole, ce qui est à la fois cool et plutôt effrayant.

Actuellement, les tests de ces fonctionnalités sont très limités et isolés au contenu en anglais et en espagnol provenant de créateurs en Amérique Latine et aux États-Unis.

Crédit : Meta

Meta ajoute également davantage de fonctionnalités d’IA générative à ses applications. Vous pouvez utiliser la fonctionnalité Imagine pour générer une image de vous dans de nombreuses situations (super-héros, royauté, astronaute, etc.), et les partager sur vos fils ; vous pouvez utiliser l’IA pour générer un nouveau fond de chat pour Messenger et les DM Instagram ; et Meta teste du contenu généré par Meta AI dans vos fils, personnalisé pour vous. (Je suis méfiant quant à l’idée d’appeler ce dernier point une “fonctionnalité”, étant donné que cela signifie encore plus de spam IA dans vos fils Meta.)

Enfin, Meta donne à “des milliers” d’entreprises la possibilité de créer des bots IA pour les interactions avec les clients. Ces bots peuvent être activés par le client via des annonces “cliquez pour envoyer un message” sur WhatsApp et Messenger.

Des lunettes Ray-Ban Meta plus intelligentes et transparentes

Crédit : Meta

Les fans des lunettes intelligentes Wayfarer que Meta fabrique avec Ray-Ban devront attendre un peu plus longtemps pour un tout nouveau modèle, mais la société technologique a tout de même présenté quelques améliorations. La plupart de ces nouveautés sont axées sur les logiciels, comme un Meta AI plus conversationnel, mais les amateurs de technologie transparente devraient être ravis : Avec l’ajout des montures “Shiny Transparent”, vous pouvez désormais obtenir les lunettes Wayfarer avec un look clair et transparent, bien qu’elles ne soient disponibles qu’en taille standard.

Elles sont livrées avec un étui de chargement noir et des verres photochromiques dès la sortie de la boîte, mais vous devrez payer 429 $ pour ce privilège, contre 299 $ pour une paire standard. Meta ne produit également que 7500 paires de ces lunettes, mais si vous manquez votre chance, ne vous inquiétez pas : des verres photochromiques seront également disponibles pour au moins une partie de la collection de cadres régulière.

Quant à ces mises à jour logicielles, toutes les lunettes Wayfarer intègrent également une intégration unique de Meta AI : Meta affirme que vous pouvez désormais dire “Hey Meta” une fois et engager une conversation avec l’assistant IA, au lieu d’avoir à dire le mot déclencheur pour chaque question. Ces lunettes se souviendront également de l’endroit où vous avez garé votre voiture, créeront des rappels à partir de demandes vocales, et agiront en fonction du texte devant vous. À ce sujet, vous pouvez demander à Meta AI d’appeler un numéro de téléphone sur un flyer que vous regardez.

Meta AI peut également enregistrer et envoyer des vidéos directement aux discussions WhatsApp et Messenger, sans besoin d’action de votre téléphone. Meta AI s’intègre également aux vidéos via vos lunettes : vous pouvez utiliser des vidéos pour demander à Meta AI de l’aide en temps réel, et Meta AI se souviendra des événements passés pour que vous puissiez poser des questions avec contexte.

Peut-être que le concept le plus intéressant est la traduction en direct. Si vous parlez à quelqu’un en espagnol, français ou italien, vos lunettes traduiront son discours en anglais, que vous entendrez à travers les haut-parleurs des lunettes. Les lunettes prennent également en charge Be My Eyes, permettant aux utilisateurs d’aider ceux qui sont aveugles ou malvoyants via un flux vidéo projeté dans leurs lunettes. Enfin, vous pouvez contrôler la lecture de musique de Spotify, Amazon Music, Audible, et iHeart avec Meta AI.

Les premières “vraies lunettes AR” de Meta

Avant de conclure ce Meta Connect, Zuckerberg a donné un aperçu d’un produit qui n’est pas encore prêt pour le marché. Selon The Verge, cela était censé être, mais la société n’est pas satisfaite de sa taille et de sa complexité, donc c’est encore interne pour le moment.

Découvrez Orion, une paire de lunettes AR qui visent à capturer les principaux atouts de l’Apple Vision Pro, mais dans un format beaucoup plus petit et plus accessible. Cela signifie des affichages d’ordinateur virtuels, des objets AR placés sur le monde réel, et même une technologie de suivi pour une interaction plus facile et des jeux légers.

Crédit : Meta

Meta qualifie l’expérience de “holographique”, bien qu’elle ne semble pas très différente de ce que vous pourriez obtenir des dispositifs Air similaires de XReal. La différence est que tout ici est propriétaire, plutôt que de dépendre de votre téléphone ou PC, avec Zuckerberg imaginant un avenir où les lunettes AR remplaceraient les téléphones.

Cela signifie également qu’elles seront équipées de fonctionnalités Meta AI semblables à celles des lunettes intelligentes Ray-Ban, ainsi que des moyens d’appeler et de naviguer sur Internet. Il y a aussi un bracelet pour aider au contrôle et un “pack de transport sans fil”, qui permet aux lunettes d’être plus petites en déplaçant les tâches de traitement sur un autre appareil. Le revers de la médaille est que ces deux accessoires sont pour l’instant requis — il n’y a pas de suivi de main sans dispositif comme sur l’Apple Vision Pro.

Crédit : Meta

Peut-être que c’est pourquoi ces lunettes sont toujours en développement, bien que Meta insiste sur le fait qu’Orion n’est “pas un prototype de recherche”, mais le qualifie plutôt de “l’un des prototypes de produit les plus raffinés que nous ayons jamais développés”. Pour l’instant, ses tests sont limités aux employés de Meta et à “un public externe sélectionné”, la société déclarant vouloir “se concentrer d’abord sur le développement interne”, bien qu’elle ait dit qu’Orion “représente véritablement quelque chose qui pourrait être expédié aux consommateurs.”

En d’autres termes, la société pense pouvoir expédier Orion tel quel, mais souhaite d’abord améliorer quelques points, peut-être en réponse à la mauvaise réception des consommateurs concernant le similaire Apple Vision Pro. Ces objectifs incluent des visuels plus nets, un format encore plus petit, et surtout, un prix plus bas.

C’est intrigant, mais nous devons malheureusement prendre Meta au mot pour que l’Orion voie le jour. La société affirme que nous “pouvons nous attendre à voir de nouveaux appareils de notre part qui s’appuient sur nos efforts de R&D” au cours “des prochaines années”, alors espérons-le.