En mai, OpenAI a annoncé le lancement d’un mode voix avancé pour ChatGPT. La société a présenté cette nouvelle fonction comme un mode voix existant en version améliorée. Vous pourriez non seulement tenir une conversation avec ChatGPT, mais les échanges seraient plus naturels : vous pourriez interrompre le bot quand vous souhaitiez changer de sujet, et ChatGPT comprendrait la vitesse et le ton de votre voix, répondant en conséquence avec ses propres émotions.

Si cela vous rappelle un peu l’assistant vocal de l’IA dans le film Her de 2013, ce n’est pas un hasard. En effet, OpenAI a fait une démonstration du produit avec une voix qui ressemblait un peu trop à celle de l’actrice Scarlett Johansson, qui prête sa voix à cette machine fictive. Johansson a décidé de porter l’affaire en justice, et la société a ensuite complètement retiré cette voix. Peu importe : il existe neuf autres voix à essayer.

Tandis qu’OpenAI a commencé à tester le mode voix avancé avec un petit groupe de testeurs en juillet, cette fonctionnalité est désormais déployée pour tous les utilisateurs payants. Si vous avez un compte éligible, vous devriez pouvoir l’essayer aujourd’hui.

Comment utiliser le mode voix avancé de ChatGPT

Pour l’instant, seuls les abonnés payants de ChatGPT peuvent accéder au mode voix avancé. Cela signifie que vous devez avoir un abonnement ChatGPT Plus ou ChatGPT Teams pour voir cette fonctionnalité. Les utilisateurs gratuits peuvent toujours utiliser le mode voix gratuit, qui apparaît dans l’application sous la forme d’une paire d’écouteurs.

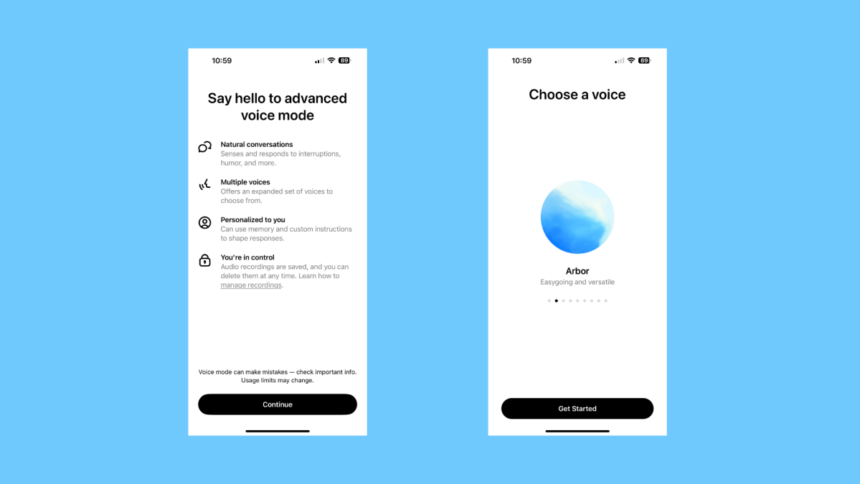

Le mode avancé se présente sous la forme d’une icône de forme d’onde, visible uniquement pour les abonnés Plus et Équipe. Pour accéder à la fonctionnalité, ouvrez une nouvelle discussion et appuyez sur cette icône. La première fois que vous utilisez le mode voix avancé, vous devrez choisir une voix parmi neuf options. Voici les descriptions fournies par OpenAI pour chacune d’elles :

-

Arbor : Décontractée et polyvalente

-

Breeze : Animée et sincère

-

Cove : Posée et directe

-

Ember : Confiant et optimiste

-

Juniper : Ouverte et pleine d’entrain

-

Maple : Joyeuse et franche

-

Sol : Avisée et détendue

-

Spruce : Calme et rassurante

-

Vale : Lumineuse et curieuse

J’ai finalement choisi Arbor, qui me rappelle beaucoup le gars de Headspace. À partir de là, le mode voix avancé fonctionne de la même manière que le mode voix standard. Vous dites quelque chose à ChatGPT, et il répond en conséquence.

Comment le mode voix avancé de ChatGPT fonctionne réellement

Dans mon expérience brève avec ce nouveau mode, je n’ai pas remarqué beaucoup d’avancées par rapport au mode voix précédent. Les nouvelles voix sont nouvelles, bien sûr, et je suppose un peu plus “naturelles” que les voix passées, mais je ne pense pas que la conversation semble plus réaliste. La capacité d’interrompre votre partenaire numérique donne un peu l’illusion, mais elle est sensible : j’ai pris mon iPhone pendant que ChatGPT parlait, et il s’est immédiatement arrêté. C’est quelque chose que j’ai aussi remarqué dans la démonstration originale d’OpenAI ; je pense qu’OpenAI doit travailler sur la capacité du bot à comprendre quand un utilisateur veut interrompre, et quand un bruit externe aléatoire se produit.

(OpenAI recommande d’utiliser des écouteurs pour éviter les interruptions indésirables, et, si vous utilisez un iPhone, d’activer le mode Isolation de la voix. J’utilisais le mode Isolation de la voix sans écouteurs, donc à vous de voir.)

Bien qu’il semble qu’OpenAI ait modéré le côté fantasque et séducteur de ChatGPT, vous pouvez toujours faire rire le bot—si vous demandez. Le rire est impressionnant pour une voix artificielle, je suppose, mais il semble peu naturel, comme s’il puisait dans un autre enregistrement pour “rire”. Demandez-lui de faire d’autres sons similaires, comme pleurer ou crier, et il refuse.

J’ai essayé de faire écouter une chanson à mon mode voix pour l’identifier, mais il a dit qu’il ne pouvait pas le faire. Le bot m’a spécifiquement demandé de partager uniquement les paroles, ce que j’ai fait, et il a suggéré une chanson basée sur les ambiance de ces paroles—pas sur les paroles elles-mêmes. En conséquence, son hypothèse était complètement erronée, mais il ne semble pas encore conçu pour ce type de tâche, donc je vais lui donner un peu de répit.

Qu’en pensez-vous jusqu’à présent ?

ChatGPT peut-il parler avec lui-même ?

J’ai dû comparer deux modes voix l’un à l’autre. La première fois que j’ai essayé, ils se sont interrompus dans un échange socialement maladroit parfait, jusqu’à ce que l’un d’eux ait buggé et répété le message qu’il m’avait précédemment adressé à propos de partager des paroles pour identifier la chanson. L’autre a alors dit quelque chose comme : “Absolument, partagez les paroles avec moi, et je vous aiderai à le découvrir.” L’autre a répondu : “Bien sûr : partagez les paroles, et je ferai de mon mieux pour identifier la chanson.” Cela a continué pendant cinq minutes avant que je mette fin à la conversation.

Une fois que j’ai configuré les chatbots avec une discussion claire, ils ont alterné indéfiniment tout en ne disant presque rien d’intéressant. Ils ont discuté de réalité augmentée, de cuisine, et de routines matinales avec le savoir-faire habituel et l’impersonnalité qui caractérisent les chatbots. Ce qui était bizarre, cependant, c’était quand l’un des bots a terminé de parler de la façon dont, s’il pouvait cuisiner, il aimerait faire des lasagnes ; il a demandé à l’autre chatbot s’il avait des plats qu’il aimait cuisiner ou était impatient d’essayer. L’autre bot a répondu : “L’utilisateur aime prendre un café et se tenir au courant des nouvelles le matin.”

C’était quelque chose que j’avais dit à ChatGPT lors d’un test passé, quand il m’avait demandé à propos de ma routine matinale. C’est une preuve que la fonction de mémoire d’OpenAI fonctionne, mais l’exécution était, euh, bizarre. Pourquoi a-t-il répondu à une question sur des recettes préférées comme ça ? Ai-je court-circuité le bot ? A-t-il réalisé qu’il discutait avec lui-même et a décidé d’avertir l’autre bot de la situation ? Je n’aime pas vraiment les implications ici.

Comment le mode voix avancé gère la vie privée des utilisateurs

Lorsque vous utilisez le mode voix avancé, OpenAI enregistre vos enregistrements—y compris les enregistrements de votre côté de la conversation. Lorsque vous supprimez une discussion, OpenAI affirme qu’il supprimera vos enregistrements audio dans les 30 jours, sauf si la société décide de les conserver pour des raisons de sécurité ou juridiques. OpenAI conservera également l’enregistrement après que vous ayez supprimé une discussion si vous avez précédemment partagé des enregistrements audio et que ce clip audio a été dissocié de votre compte.

Pour vous assurer que vous ne laissez pas OpenAI entraîner ses modèles avec vos enregistrements vocaux et transcriptions de conversation, allez dans les paramètres de ChatGPT, choisissez Contrôles de données, puis désactivez Améliorer le modèle pour tout le monde et Améliorer la voix pour tout le monde.