Google a annoncé un nouveau tour d’actualisations importantes de ses modèles d’IA, mettant à jour ses offres Gemini dans tous les domaines pour offrir aux utilisateurs et aux développeurs des moteurs d’intelligence artificielle qui, selon la société, sont plus capables et fiables. À la suite de la montée de DeepSeek et des nouveaux modèles d’OpenAI, le rythme de développement de l’IA ne ralentit pas.

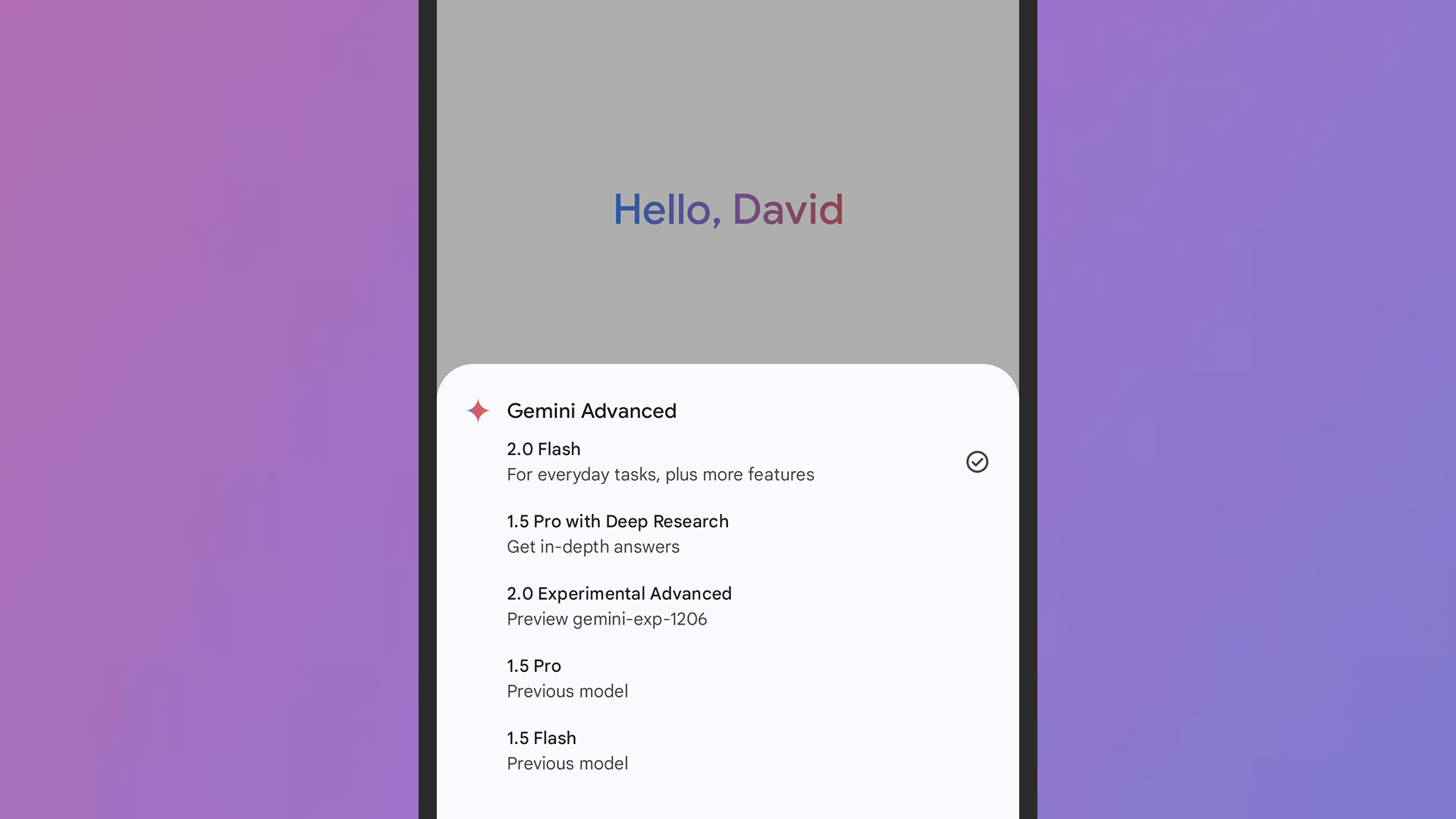

Tout d’abord, le modèle Gemini 2.0 Flash, qui est apparu en décembre pour un nombre restreint d’utilisateurs, est désormais déployé pour tout le monde, vous le verrez donc dans les applications Gemini sur bureau et mobile (cela a en fait commencé à apparaître la semaine dernière, vous l’avez peut-être déjà utilisé). Les modèles Flash sont conçus pour être plus rapides et plus légers, sans trop de compromis sur les performances.

Google propose également un modèle expérimental de raisonnement Gemini 2.0 Flash Thinking à tous les utilisateurs pour test. C’est un autre modèle de « raisonnement », comme ceux que nous avons vus dans ChatGPT, où l’IA affiche son processus de pensée au fur et à mesure, avec l’intention de produire des résultats plus précis et transparents.

Une version de ce modèle sera également accessible à tous les utilisateurs ayant accès aux applications incluses : Google Search, Google Maps et YouTube. Il renverra des informations en temps réel depuis le web, ainsi que des références aux données de Google Maps (y compris les temps de trajet et les détails de localisation), et des informations tirées des vidéos YouTube.

Enfin, pour les modèles Flash, Google rend le modèle Gemini 2.0 Flash-Lite disponible pour les développeurs. C’est le modèle Gemini le plus économique à ce jour, ce qui attirera ceux qui construisent des outils avec Gemini, tout en maintenant des niveaux de performance élevés à travers une variété d’entrées multimodales (texte, images, et plus).

Modèles professionnels

Crédit : Cours Technologie

Ensuite, le modèle expérimental même plus capable Gemini 2.0 Pro est là—un peu plus lent que les équivalents Flash, mais meilleur en pensée, rédaction, programmation et résolution de problèmes. Ce modèle apparaît désormais sous forme expérimentale pour les développeurs et pour tous les utilisateurs qui paient 20 $ par mois pour Gemini Advanced.

« Il a la meilleure performance en matière de codage et la capacité de gérer des requêtes complexes, avec une meilleure compréhension et un raisonnement sur les connaissances du monde, que n’importe quel modèle que nous avons publié jusqu’à présent, » déclare Google. Il peut également traiter deux millions de tokens par requête, ce qui équivaut à environ 1,4 million de mots—environ la Bible, deux fois.

C’est le double de la capacité des modèles 2.0 Flash, et Google a également fourni quelques références de performance. Dans l’évaluation MMLU-Pro générale, nous avons obtenu des scores de 71,6 %, 77,6 % et 79,1 % respectivement pour Gemini 2.0 Flash-Lite, 2.0 Flash, et 2.0 Pro, comparé à 67,3 % pour 1.5 Flash et 75,8 % pour 1.5 Pro.

Des améliorations similaires ont été observées sur d’autres évaluations d’IA, avec Gemini 2.0 Pro Experimental atteignant un score de 91,8 % dans un test de mathématiques de premier plan. Cela se compare à 90,9 % pour 2.0 Flash, 86,8 % pour Flash-Lite, 86,5 % pour 1.5 Pro, et 77,9 % pour 1.5 Flash.

Comme c’est la norme pour le lancement de modèles d’IA comme celui-ci, les informations sur les données de formation utilisées, les risques d’hallucination et d’inexactitudes, et les exigences énergétiques sont minces—bien que Google affirme que les nouveaux modèles Flash sont ses plus efficaces à ce jour, tandis que tous ses derniers modèles sont meilleurs que jamais pour traiter les retours de raisonnement et stopper les hacks potentiels de sécurité.